reklama

jestli ty provozovat web 10 způsobů, jak vytvořit malý a jednoduchý web bez nadměrného množstvíWordPress může být nadměrný. Jak tyto další vynikající služby dokazují, WordPress není vše a končí veškerou tvorbou webových stránek. Pokud chcete jednodušší řešení, můžete si vybrat z celé řady. Přečtěte si více , pravděpodobně jste slyšeli o souboru robots.txt (nebo „standardu vyloučení robotů“). Ať už to máte nebo ne, je čas se o tom dozvědět, protože tento jednoduchý textový soubor je rozhodující součástí vašeho webu. Může se to zdát nevýznamné, ale možná vás překvapí, jak je to důležité.

Pojďme se podívat, co je soubor robots.txt, co dělá a jak jej správně nastavit pro svůj web.

Co je soubor robots.txt?

Abyste porozuměli tomu, jak soubor robots.txt funguje, musíte vědět trochu o vyhledávačích Jak fungují vyhledávače?Pro mnoho lidí je Google internet. Je to pravděpodobně nejdůležitější vynález od samotného internetu. A zatímco se vyhledávače od té doby hodně změnily, základní principy jsou stále stejné. Přečtěte si více

. Krátká verze je, že rozesílají „prolézací moduly“, což jsou programy, které vyhledávají na internetu informace. Poté některé informace uloží, aby k nim mohli lidi později nasměrovat.Tyto prohledávače, také známé jako „roboti“ nebo „pavouci“, vyhledávají stránky z miliard webových stránek. Vyhledávače jim dávají pokyny, kam mají jít, ale jednotlivé weby mohou také komunikovat s roboty a říkat jim, na které stránky by se měly dívat.

Většinou dělají pravý opak a říkají jim, na kterých stránkách neměla by dívat se na. Věci, jako jsou administrativní stránky, backendové portály, stránky kategorií a značek, a další věci, které majitelé stránek nechtějí zobrazovat ve vyhledávačích. Tyto stránky jsou stále viditelné pro uživatele a jsou přístupné každému, kdo má svolení (což je často každý).

Ale tím, že řeknete těmto pavoukům, aby neindexovaly některé stránky, udělá soubor robots.txt každému laskavost. Pokud jste hledali „MakeUseOf“ ve vyhledávači, chtěli byste, aby se naše stránky pro správu zobrazovaly vysoko v žebříčku? Ne. To by nikomu neprospělo, proto říkáme vyhledávačům, aby je nezobrazovaly. Může být také použit k zabránění vyhledávačům v odhlášení z stránek, které by jim nemusely pomoci klasifikovat váš web ve výsledcích vyhledávání.

Stručně řečeno, soubor robots.txt říká webovým prohledávačům, co dělat.

Mohou Crawlers Ignore robots.txt?

Prohledávače někdy ignorují soubory robots.txt? Ano. Ve skutečnosti je mnoho prohledávačů dělat ignorovat to. Obecně však tyto prohledávače nepocházejí z renomovaných vyhledávačů. Pocházejí z spammerů, e-mailů a jiné typy automatizovaných robotů Jak vytvořit základní webový prohledávač pro stahování informací z webuChtěli jste někdy zachytit informace z webové stránky? Zde je návod, jak napsat prolézací modul pro procházení webu a extrahování toho, co potřebujete. Přečtěte si více který se potuluje po internetu. Je důležité mít na paměti - použití standardu pro vyloučení robotů k tomu, aby robotům řekl, aby se vyhnuli, není účinným bezpečnostním opatřením. Ve skutečnosti by někteří roboti mohli Start se stránkami, které jim řeknete, aby nechodily.

Vyhledávací stroje však budou dělat, jak říká váš soubor robots.txt, pokud je správně naformátován.

Jak napsat soubor robots.txt

Existuje několik různých částí, které přecházejí do standardního souboru pro vyloučení robotů. Zde je rozložím jednotlivě.

Prohlášení uživatelského agenta

Než řeknete botovi, na které stránky by se nemělo dívat, musíte určit, s kterým botem mluvíte. Většinou budete používat jednoduché prohlášení, které znamená „všichni roboti“. Vypadá to takto:

User-agent: *Hvězdička znamená „všechny roboty“. Můžete však určit stránky pro určité roboty. Chcete-li to provést, musíte znát název robota, pro který stanovujete pokyny. Může to vypadat takto:

User-agent: Googlebot. [seznam stránek, které se nemají procházet] User-agent: Googlebot-Image / 1.0. [seznam stránek, které se nemají procházet] User-agent: Bingbot. [seznam stránek, které se nemají procházet]A tak dále. Pokud objevíte robota, který nechcete procházet své stránky, můžete to také určit.

Názvy agentů uživatelů najdete na adrese useragentstring.com [No Longer Available].

Zakázání stránek

Toto je hlavní část vašeho souboru pro vyloučení robotů. Jednoduchým prohlášením řeknete botovi nebo skupině robotů, aby určité stránky neprolézali. Syntaxe je snadná. Takto zakážete přístup ke všemu v adresáři „admin“ vašeho webu:

Disallow: / admin /Tento řádek by zabránil robotům procházet stránky yoursite.com/admin, yoursite.com/admin/login, yoursite.com/admin/files/secret.html a cokoli jiného, co spadá do adresáře admin.

Chcete-li zakázat jednu stránku, stačí ji zadat do řádku pro zakázání:

Disallow: /public/exception.htmlStránka „Výjimka“ nyní nebude nakreslena, ale všechno ostatní ve složce „veřejnost“ bude.

Chcete-li zahrnout více adresářů nebo stránek, stačí je uvést na následujících řádcích:

Disallow: / private / Disallow: / admin / Disallow: / cgi-bin / Disallow: / temp /Tyto čtyři řádky se použijí na libovolného uživatelského agenta, kterého jste uvedli v horní části sekce.

Pokud chcete zabránit robotům v prohlížení jakékoli stránky na vašem webu, použijte toto:

Disallow: /Stanovení různých standardů pro roboty

Jak jsme viděli výše, můžete určit určité stránky pro různé roboty. Kombinace předchozích dvou prvků vypadá takto:

User-agent: googlebot. Disallow: / admin / Disallow: / private / User-agent: bingbot. Disallow: / admin / Disallow: / private / Disallow: / secret /Sekce „administrátor“ a „soukromý“ budou na Googlu a Bingu neviditelné, ale Google uvidí „tajný“ adresář, zatímco Bing nebude.

Obecná pravidla pro všechny roboty můžete určit pomocí uživatelského agenta hvězdičky a poté robotům v dalších sekcích také dát konkrétní pokyny.

Dát to všechno dohromady

S výše uvedenými znalostmi můžete napsat kompletní soubor robots.txt. Stačí spustit váš oblíbený textový editor (jsme fanoušci Sublime 11 skvělých textových tipů pro produktivitu a rychlejší pracovní postupSublime Text je univerzální textový editor a zlatý standard pro mnoho programátorů. Naše tipy se zaměřují na efektivní kódování, ale běžní uživatelé ocení klávesové zkratky. Přečtěte si více tady) a začněte informovat roboty, že nejsou vítáni v určitých částech vašeho webu.

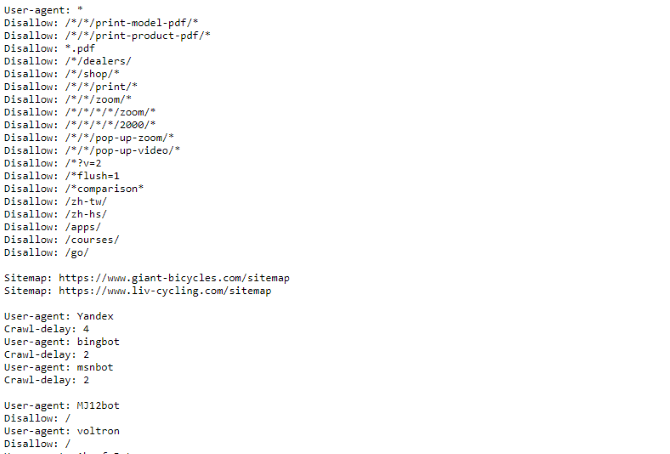

Pokud chcete vidět příklad souboru robots.txt, stačí zamířit na libovolný web a na konec přidat „/robots.txt“. Zde je část souboru robots.txt Giant Bicycles:

Jak vidíte, existuje několik stránek, které se ve vyhledávačích nechtějí zobrazovat. Zahrnuli také několik věcí, o kterých jsme ještě nemluvili. Pojďme se podívat, co dalšího můžete v souboru vyloučení robotů udělat.

Vyhledání souboru Sitemap

Pokud váš soubor robots.txt řekne robotům, kde ne jít mapa stránek dělá opak Jak vytvořit soubor XML Sitemap ve 4 snadných krocíchExistují dva typy souborů Sitemap - stránka HTML nebo soubor XML. Soubor Sitemap HTML je jediná stránka, která návštěvníkům zobrazuje všechny stránky na webu a obvykle obsahuje odkazy na tyto stránky ... Přečtěte si více a pomáhá jim najít to, co hledají. A přestože vyhledávače pravděpodobně již vědí, kde je váš soubor Sitemap, nebolí jim to znovu vědět.

Prohlášení o umístění souboru Sitemap je jednoduché:

Mapa stránek: [URL souboru Sitemap]A je to.

V našem vlastním souboru robots.txt to vypadá takto:

Mapa stránek: //www.makeuseof.com/sitemap_index.xmlTo je všechno.

Nastavení zpoždění procházení

Směrnice pro zpoždění procházení říká určitým vyhledávačům, jak často mohou indexovat stránku na vašem webu. Měří se v sekundách, i když některé vyhledávače to interpretují trochu jinak. Někteří vidí zpoždění procházení 5, protože jim říkají, aby po každém procházení počkali pět sekund, aby zahájili další. Jiní to interpretují jako pokyn k procházení pouze jedné stránky každých pět sekund.

Proč byste řekli prolézacímu modulu, aby neprolézal co nejvíce? Na zachovat šířku pásma 4 způsoby Windows 10 ztrácí vaši internetovou šířku pásmaZtrácí Windows 10 vaši internetovou šířku pásma? Zde je návod, jak to zkontrolovat a co můžete udělat, abyste to zastavili. Přečtěte si více . Pokud se váš server snaží udržet krok s provozem, můžete zkusit zpoždění procházení. Obecně se většina lidí o to nemusí starat. Velké stránky s velkým provozem však mohou chtít trochu experimentovat.

Takto nastavíte zpoždění procházení 8 sekund:

Zpoždění procházení: 8A je to. Ne všechny vyhledávače se budou řídit vaší směrnicí. Ale není na škodu se zeptat. Stejně jako u zakázaných stránek můžete nastavit různá zpoždění procházení pro konkrétní vyhledávače.

Nahrávání souboru robots.txt

Až budete mít všechny pokyny ve svém souboru nastaveny, můžete je nahrát na svůj web. Ujistěte se, že se jedná o prostý textový soubor a má název robots.txt. Poté jej nahrajte na svůj web, abyste jej našli na stránce yoursite.com/robots.txt.

Pokud používáte a systém pro správu obsahu 10 nejoblíbenějších systémů pro správu obsahu onlineDny ručně kódovaných stránek HTML a zvládnutí CSS jsou dávno pryč. Nainstalujte systém pro správu obsahu (CMS) a během několika minut můžete mít web, který budete sdílet se světem. Přečtěte si více jako je WordPress, pravděpodobně existuje konkrétní způsob, jak to udělat. Protože se liší v každém systému správy obsahu, budete si muset prostudovat dokumentaci k vašemu systému.

Některé systémy mohou mít také online rozhraní pro nahrávání vašeho souboru. Pro tyto stačí zkopírovat a vložit soubor, který jste vytvořili v předchozích krocích.

Nezapomeňte aktualizovat svůj soubor

Poslední radu, kterou poskytnu, je občas si prohlédnout soubor s vyloučením robota. Váš web se změní a možná budete muset provést určité úpravy. Pokud si všimnete podivné změny v provozu vašeho vyhledávače, je dobré si soubor také prohlédnout. Je také možné, že se standardní notace v budoucnu změní. Stejně jako všechno ostatní na vašem webu, stojí za to jej zkontrolovat jednou za čas.

Na kterých stránkách z vašeho webu vyloučíte prolézací moduly? Všimli jste si nějakého rozdílu v provozu vyhledávačů? Podělte se o své rady a komentáře níže!

Dann je konzultant pro obsahovou strategii a marketing, který pomáhá společnostem vytvářet poptávku a vede. Také blogy o strategii a marketingu obsahu na dannalbright.com.